Sesgos de reconocimiento facial, racismo y control estatal: por qué el uso de datos biométricos ha sido el mayor escollo en la ley de inteligencia artificial

Tras tres días de intensas negociaciones, los Estados europeos y la Eurocámara acordaron que esta tecnología sea utilizada por las fuerzas de seguridad solo en ciertas circunstancias, como terrorismo o explotación sexual

La UE da el primer paso en el mundo para regular la Inteligencia Artificial

Madrid

Esta funcionalidad es sólo para registrados

Iniciar sesiónLa Unión Europea aprobó el viernes la primera gran regulación del mundo del uso de la inteligencia artificial (IA) después de tres días de intensas negociaciones. El texto define las normas de una tecnología que parece imparable pero cuyas posibilidades y riesgos aún ... desconocemos y quizás ni siquiera somos capaces de imaginar. El texto, firmado por los Estados miembros y el Parlamento Europeo, todavía es provisional y debe ser ratificado por ambas partes. El punto más polémico, que supuso el retraso del acuerdo, ha sido la regulación del uso de las cámaras de reconocimiento facial (vigilancia biométrica) en espacios públicos.

El Parlamento quería que fueran prohibidas, pero los gobiernos han presionado hasta lograr que las fuerzas de seguridad puedan utilizarlas en casos justificados, como la prevención del terrorismo, secuestros o la explotación sexual, con previa autorización judicial y escrutinio independiente.

Los sistemas de reconocimiento facial, capaces de categorizar a una persona en función de sus rasgos faciales, gestos y comportamiento, llevan tiempo con nosotros. Es la misma tecnología que utilizamos en el móvil para desbloquearlo o pagar en la banca online sin tener que utilizar un código numérico. Pero la legislación de su uso público es especialmente delicada y ha abierto un gran debate ético por la posibilidad de que estos sistemas creen sesgos, y se utilicen para catalogar a una persona como conflictiva a partir de su comportamiento y características personales.

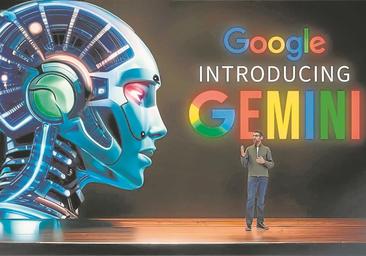

Google reta al mundo con una nueva inteligencia artificial que parece de ciencia ficción

Rodrigo AlonsoGemini puede relacionarse con el usuario mediante vídeo, audio o imágenes. Ofrece mejores resultados y comete menos errores que ChatGPT, pero no ha sido probada por terceros

En 2021, un grupo compuesto por más de 70 académicos, juristas y personalidades del ámbito tecnológico enviaron una carta al Gobierno español solicitando una moratoria en el uso de estos sistemas, ya que, según denunciaban, pueden asociar una persona a un patrón erróneo. Argumentaban que, «más allá de correlaciones estadísticas» no hay modelos científicos aceptados que indiquen que un tipo de nariz, un rictus o una cadencia al caminar sean predictores adecuados de comportamientos individuales futuros.

Prevenir delitos

Por el contrario, destacaban que esta tecnología todavía tiene «graves deficiencias», fomenta las «clasificaciones racistas, clasistas y/o sexistas» y que, en algunas partes del mundo, su empleo está limitando derechos fundamentales. En los países con menos derechos reconocidos puede utilizarse para monitorizar a la población. China incluso ha estudiado la implementación de estas herramientas de reconocimiento facial en espacios públicos para predecir la comisión de delitos y la realización de protestas. Si un individuo sospechoso (porque tenga antecedentes penales, ha participado en protestas o sufre un problema mental) se sale de su rutina, las autoridades podrían investigar la posible comisión de un delito. Pero además serviría también para controlar minorías étnicas o inmigrantes.

Sobre la nueva ley europea, Claudio Novelli, investigador posdoctoral del departamento de Estudios Jurídicos de la Universidad de Bolonia (Italia) e international fellow del Digital Ethics Center de la Universidad de Yales (EEUU), explica al Science Media Centre (SMC) que abandonar la autorregulación de los modelos de IA y optar por la supervisión directa fue «un paso necesario» y prohibir la mayoría de los sistemas biométricos, «una medida prudente».

MÁS INFORMACIÓN

«Si la ley es efectiva lo veremos con el paso del tiempo. En principio, la regulación debería ser lo suficientemente flexible para adaptarse a los nuevos avances tecnológicos que cada vez se dan más rápido y, al mismo tiempo, lo suficientemente concreta para poder evitar situaciones que pueden ser muy graves y sancionar cuando sea necesario», dice a SMC Lucía Ortiz de Zárate, investigadora predoctoral en Ética y Gobernanza de la Inteligencia Artificial en el departamento de Ciencia Política y Relaciones Internacionales de la Universidad Autónoma de Madrid. «En cualquier caso -continúa-, es una buena noticia que la UE haya apostado por regular la IA y poner algunos límites a unas tecnologías que, sin control, podrían ser terriblemente dañinas, incluso sin nosotros ser conscientes de ello».

Esta funcionalidad es sólo para suscriptores

Suscribete

Esta funcionalidad es sólo para registrados

Iniciar sesiónEsta funcionalidad es sólo para suscriptores

Suscribete