Una 'neuroprótesis' devuelve la capacidad de hablar a un hombre con parálisis cerebral

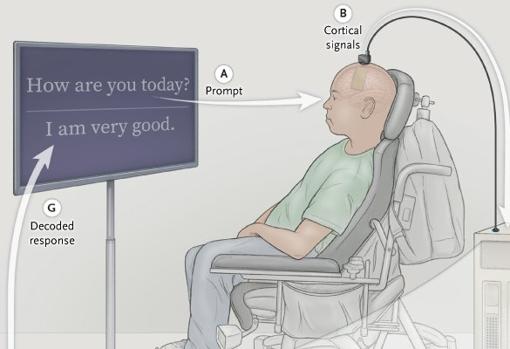

Una 'neuroprótesis del habla' permite a un hombre con parálisis cerebral comunicarse al traducir señales de su cerebro al tracto vocal y convertirlas en palabras que aparecen como texto en una pantalla

R. Ibarra

Desde que en 2003 sufriera un accidente automovilístico, Bravo1 no había podido hablar. Bravo1, es el nombre por el que se conoce, quedó paralizado a los 20 años por un derrame cerebral grave después de un terrible accidente.

Ahora, investigadores de UC San Francisco (EE.UU.) ... , se la han devuelto. En un nuevo hito científico , los investigadores han aprovechado las áreas del habla de su cerebro, permitiéndole producir palabras y oraciones comprensibles simplemente tratando de decirlas. Cuando Bravo1 intenta hablar, los electrodos implantados en su cerebro transmiten señales a una computadora que las muestra en la pantalla.

El logro se basa en más de una década de esfuerzos del neurocirujano Edward Chang para desarrollar una tecnología que permita a las personas con parálisis comunicarse. El estudio se publica hoy en la revista «The New England Journal of Medicine».

«Hasta donde sabemos, esta es la primera vez que se logra con éxito la decodificación directa de palabras completas de la actividad cerebral de una persona con parálisis que no tiene la capacidad de hablar» asegura Chang, autor principal del estudio, lo que supone una gran esperanza para «restaurar la comunicación al aprovechar la maquinaria del habla natural del cerebro».

Cada año, miles de personas pierden la capacidad de hablar debido a un derrame cerebral, un accidente o una enfermedad . Con un mayor desarrollo, este enfoque podría algún día permitir que estas personas se comuniquen completamente.

Las investigaciones previas en el campo de la neuroprótesis de la comunicación se han centrado en restaurar la comunicación a través de enfoques basados en la ortografía para escribir las letras una a una en el texto.

La aproximación del grupo de Chang difiere de esta línea de una manera crítica: su equipo está traduciendo señales destinadas a controlar los músculos del sistema vocal que se usa para formar palabras

Pero la aproximación del grupo de Chang difiere de esta línea de una manera crítica: su equipo está traduciendo señales destinadas a controlar los músculos del sistema vocal que se usa para formar palabras, en lugar de señales para mover el brazo o la mano para permitir la escritura.

Chang dijo que este enfoque aprovecha los aspectos naturales y fluidos del habla y promete una comunicación más rápida y orgánica .

«Cuando hablamos, normalmente transmitimos información a una velocidad muy elevada, hasta 150 o 200 palabras por minuto», explica, mientras que los enfoques basados en la ortografía que utilizan mecanografía, escritura y control de un cursor son considerablemente más lentos y laboriosos.

«Ir directo a las palabras, como lo estamos haciendo aquí, tiene grandes ventajas porque está más cerca de cómo hablamos normalmente».

Durante la última década, el equipo de Chang ha probado su idea en pacientes del Centro de Epilepsia de UCSF que se sometían a neurocirugía para identificar el origen de sus convulsiones utilizando conjuntos de electrodos colocados en la superficie de sus cerebros. Estos pacientes, todos los cuales tenían un habla normal, se ofrecieron como voluntarios para analizar sus grabaciones cerebrales en busca de actividad relacionada con el habla. El éxito inicial con estos voluntarios allanó el camino para el ensayo actual en personas con parálisis.

En colaboración con el Instituto Weill de Neurociencias de la UCSF mapearon los patrones de actividad cortical asociados con los movimientos del tracto vocal que producen cada consonante y vocal. Para traducir esos hallazgos en el reconocimiento de voz de palabras completas, David Moses , uno de los autores principales del estudio, desarrolló nuevos métodos para la decodificación en tiempo real de esos patrones y modelos estadísticos de lenguaje para mejorar la precisión.

Pero su éxito en la decodificación del habla en los participantes que podían hablar no garantizaba que la tecnología funcionara en una persona cuyo tracto vocal está paralizado.

«Nuestros modelos necesitaban aprender el mapeo entre los patrones complejos de actividad cerebral y el habla intencionada –expone Moses–. Eso plantea un gran desafío cuando el participante no puede hablar».

Además, el equipo no sabía si las señales cerebrales que controlan el tracto vocal seguirían intactas en las personas que no han podido mover sus músculos vocales durante muchos años.

Para investigar el potencial de esta tecnología en pacientes con parálisis, se inició el estudio BRAVO (Restauración de la interfaz cerebro-computadora del brazo y la voz).

El primer participante en el ensayo ha sido un hombre de unos 30 años que sufrió un devastador derrame cerebral hace más de 15 años que dañó gravemente la conexión entre su cerebro y su tracto vocal y sus extremidades. Desde su lesión, ha tenido movimientos de cabeza, cuello y extremidades extremadamente limitados, y se comunica mediante el uso de un puntero adherido a una gorra de béisbol para marcar letras en una pantalla.

Bravo1 trabajó con los investigadores para crear un vocabulario de 50 palabras que el equipo de Chang pudo reconocer a partir de la actividad cerebral utilizando algoritmos informáticos avanzados. El vocabulario, que incluye palabras como «agua», «familia» y «bueno», fue suficiente para crear cientos de oraciones que expresan conceptos aplicables a la vida diaria del paciente.

El equipo implantó quirúrgicamente una matriz de electrodos de alta densidad sobre la corteza motora del habla de Bravo1. Después de la recuperación completa del participante, su equipo registró 22 horas de actividad neuronal en esta región del cerebro durante 48 sesiones y varios meses.

En cada sesión, el paciente intentó decir cada una de las 50 palabras del vocabulario , muchas veces mientras los electrodos registraban las señales cerebrales de su corteza del habla.

Para traducir los patrones de actividad neuronal registrada en palabras específicas, los otros dos autores principales del estudio, Sean Metzger y Jessie Liu , utilizaron modelos de redes neuronales personalizados, una forma de inteligencia artificial. Así, cuando el participante intentaba hablar, estas redes distinguían patrones sutiles en la actividad cerebral para detectar intentos de habla e identificar qué palabras estaba tratando de decir.

Para probar su enfoque, el equipo primero presentó a BRAVO1 oraciones cortas construidas a partir de las 50 palabras del vocabulario y le pidió que intentara decirlas varias veces. Mientras lo intentaba, las palabras fueron decodificadas de su actividad cerebral, una por una, en una pantalla.

Luego, el equipo le hizo preguntas como «¿Cómo estás hoy?» y «¿Quieres un poco de agua?». Como antes, el intento de discurso de BRAVO1 apareció en la pantalla. «Estoy muy bien» y «No, no tengo sed».

De esta forma descubrieron que el sistema podía decodificar palabras de la actividad cerebral a una velocidad de hasta 18 palabras por minuto con una precisión de hasta el 93% (mediana del 75%).

El modelo de lenguaje que Moses aplicó contribuyó al éxito ya que implementó una función de «autocorrección», similar a la que utilizan los programas de reconocimiento de voz. «Hemos demostrado que es posible facilitar la comunicación de esta manera y que tiene potencial para usarse en una conversación», concluye Moses.

De cara al futuro, Chang y Moses dijeron que ampliarán el ensayo para incluir a más participantes afectados por parálisis severa y déficits de comunicación. Actualmente, el equipo está trabajando para aumentar la cantidad de palabras en el vocabulario disponible, así como para mejorar la velocidad del habla.

Límite de sesiones alcanzadas

- El acceso al contenido Premium está abierto por cortesía del establecimiento donde te encuentras, pero ahora mismo hay demasiados usuarios conectados a la vez. Por favor, inténtalo pasados unos minutos.

Has superado el límite de sesiones

- Sólo puedes tener tres sesiones iniciadas a la vez. Hemos cerrado la sesión más antigua para que sigas navegando sin límites en el resto.

Esta funcionalidad es sólo para suscriptores

Suscribete

Esta funcionalidad es sólo para registrados

Iniciar sesiónEsta funcionalidad es sólo para suscriptores

Suscribete